|

|

|

||||||

|

||||||

|

Johannes Gfeller Wir hätten gerne:

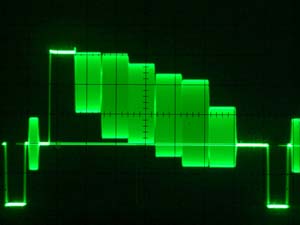

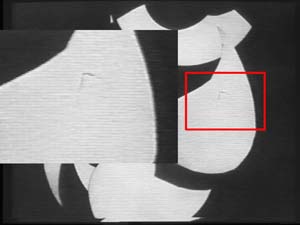

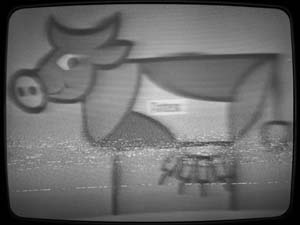

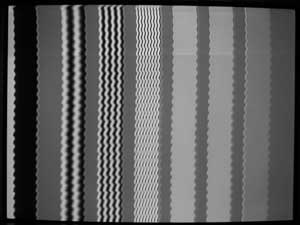

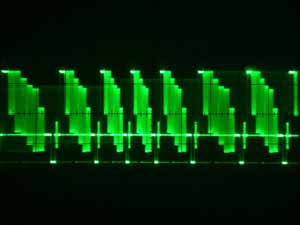

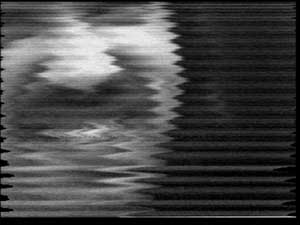

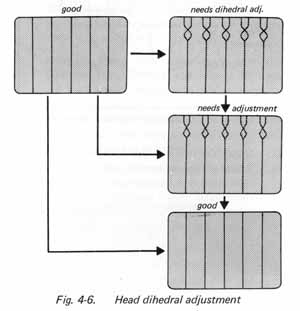

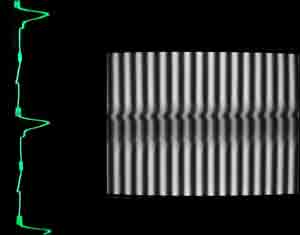

Vergessen wir es gemeinsam, dann fällt es leichter. Einige Bemerkungen zum historischen Verhältnis von Film und VideoIm Alltagsverständnis der meisten von uns gibt es vermutlich, was die technischen Bildmedien angeht, eine historische Genealogie, die wie folgt hochzuzählen ist: Fotografie, Film, Fernsehen, Video, digitale Medien, das eine jeweils vor dem Hintergrund des vorhergehenden entstanden. Die erdrückende Kraft des Faktischen bestätigt zwar diese Sicht, dennoch ist auf einen historischen Subtext aufmerksam zu machen, der dann ein etwas anderes Bild abgibt: Fotografie und Telegrafie tauchen ungefähr gleichzeitig in der Geschichte auf, nämlich Mitte der Dreissiger Jahre des 19. Jhrh. Telegrafie ist ein digitales Übertragungs- und Speichermedium. Rund fünfzig Jahre später, Mitte der 1880er Jahre entstehen erste Artefakte bzw. Patente für bewegte Bilder: Etienne-Jules Marey steht hier für den Film, aus seiner Chronophotographie entstanden, und Paul Nipkow für das Fernsehen, welches grundsätzlich auf telegrafischer Technologie beruht und die Erfahrungen mit analogen Signalen zu nutzen weiss, wie sie das Telefon damals seit knapp 10 Jahren macht. Die Filmindustrie entwickelt sich zwar schneller und ist zur Zeit der ersten regulären Fernsehversuche Ende der 20er Jahre ein voll ausgebildeter Wirtschaftszweig, aber die zeitlichen Wurzeln von Film und Fernsehen liegen fast aufs Jahr genau nebeneinander und dürften im übrigen unabhängig voneinander erdacht worden sein. Wir brauchen die Zahlen nicht über Gebühr zurechtzubiegen, wenn wir behaupten, dass die Entwicklung der analogen Videotechnik und diejenige der digitalen Rechner auch in etwa gleichzeitig erfolgt: nämlich in der ersten Hälfte der fünfziger Jahre des 20 Jahrhunderts – selbstverständlich sind auch mir die früheren Artefakte von Rechnern nicht unbekannt. Es ist daraus keine Geschichtsphilosophie zu klittern, bloss die Vermutung anzubringen, dass das Medium sozusagen seine eigene technische, ökonomische und aesthetische Herkunft immer mit sich herumträgt. Die technische und die aesthetische Annäherung von Film und Video, die eigentlich seit fast 50 Jahren stattfinden könnte, hat sich erst im letzten Jahrzehnt angebahnt und ist alles andere als vollzogen. Seit wenigen Jahren erst treffen wir in der bildenden Kunst auf einen ausgesprochen cinematographischen Gebrauch von Video, der genausogut als videografische Auswertung von filmischer Produktionsweise zu sehen ist. Filmrestaurierung oder Videorestaurierung ?Und damit sind wir sozusagen beim Thema angelangt: filmische und videografische Techniken für die Restaurierung bewegter Bilder. Ich formuliere es absichtlich noch nicht so, wie Sie es vermutlich jetzt dann langsam erwarten: digitale Restaurierung von analogem Video. Weil: da klebt noch was. Restaurierung von Film ist ursprünglich ein opto-chemischer Vorgang mit viel Handarbeit dazwischen. Der Vorgang ist teuer, dementsprechend die Produktivität gering, die Archive immens gross und die Uhr tickt. Es wundert deshalb nicht, dass sich nur schon rein für die Tradierung dieser Inhalte das Überspielen auf Video angeboten hat, zumal dies auch gleichzeitig das mögliche Sendeformat für eine TV-Auswertung und einen DVD-Verkauf ist. Beide Formen existieren bis auf den heutigen Tag nebeneinander: die klassische opto-chemische und die videografische Übertragung. In Amerika mit dem NTSC-System von 30 Bildern pro Sekunden sind 24 Filmbilder pro Sekunde auf 60 Halbbilder Video zu verteilen, two three pulldown nennt sich das. Sämtliche Fehler des Filmbildes plus die Artefakte der Übertragung finden sich selbstverständlich auf der Videokopie wieder. Frühestes reguläres Fernsehen der 50er Jahre ist, wenn überhaupt, ausschliesslich auf Film aufgenommen, mitsamt seinen Fernsehzeilen. Diesen Zeugnissen noch vor der Videoaufzeichnung kommt ein hohes geschichtliches wie mediengeschichtliches Interesse zu. Sie werden also erneut in den Abtaster eingespannt, der auch nicht anders kann, als dieses Filmbild wiederum in Zeilen aufzulösen – das ist sozusagen sein Zweck. Zeile über Zeile ergibt notwendigerweise Moiré und damit ein Problem, das man heute gerne gelöst hätte. Frühes Fernsehen zeichnet mit quer zur Bandrichtung liegenden Spuren auf 2 Zoll breites Band auf. Immer nach 16 Zeilen ist Kopfumschaltung angesagt, mit möglichem sichtbarem Versatz im Bild. Die Zweizollfehler sind ausführlich technisch beschrieben worden, weil hier das ökonomische Interesse an diesen Inhalten mit dem Verschwinden der Geräte aus den Studios und namentlich den Fernsehanstalten erwacht ist. Aus kulturhistorischen Gründen allein würde wohl auch auf Broadcast-Ebene kein nennenswerter Aufwand für die Rettung der Inhalte betrieben, hingegen ist das hauseigene Bildarchiv als auch finanziell bezifferbare Programmquelle erkannt worden, was letztlich die grossen Forschungs- und Transferprogramme auf EU-Ebene mitausgelöst hat. Wir haben also die – im Übrigen allenfalls aus ökonomischen Gründen vertretbare – Übertragung von Film auf Video in dessen Standardauflösung, und wir haben die genuinen Videoarchive namentlich im Broadcastbereich. Beide zusammengenommen sind sie ökonomisch interessant, um sie digital aufzuarbeiten, zumal ein Transfer der analogen Archive so oder so ansteht, will man sie nicht verlieren. Als Access-Medium hat sich die DVD durchgesetzt, und die hat einen strengen Pförtner: Die Daten müssen drastisch reduziert werden, damit sie auf der DVd nicht Unruhe der verpixelten Art stiften. Und daraus wird nun ein grosses Paket geschnürt: digitale Aufarbeitung der Daten, sprich Elimination der klassischen Filmfehler, allenfalls notwendige Korrekturen der degradierten Tonwerte, pauschale Verminderung des Bildrauschens, das Korn des Films ist dann grad noch mitgemeint, dafür werden die Kanten etwas geschärft, weil die Übertragungsprozesse ja immer auch optisch gesehen verlustbehaftet sind. Technische Notwendigkeit und Publikumsgeschmack treffen sich hier in idealer Weise. Unter der Oberfläche des Bildes passiert aber noch viel mehr, das wir mit etwas Übung gelegentlich wahrnehmen können. Ich erkläre kurz: ein mehr oder weniger unbewegtes Bild kann ich entrauschen, nicht indem ich die hohen Frequenzen im Signal vermindere, damit würde ich Auflösung preisgeben, sondern indem ich die zeitlich aufeinanderfolgenden Einzelbilder übereinanderlege und die Mittelwerte der Helligkeiten bzw. Farben des jeweiligen Pixelortes rechne. Die Information profiliert sich, das Rauschen als chaotisches Störsignal, hebt sich tendenziell auf. Sobald ich Bewegung im Bild habe, geht das natürlich nicht, weil die bewegten Gegenstände oder Personen Fahnen nach sich ziehen würden. Ich muss also ihre Bewegungsrichtung analysieren, sie vom un- oder anders bewegten Hintergrund lösen und sie als freie Objekte behandeln. Damit kann ich Teile des Hintergrundes vom letzten Bild übernehmen, weil er sich nicht verändert hat, und ich kann für die Rauschverminderung das bewegte Objekt mittels movement prediction im neuen Bild am richtigen Ort für die Mittelwertbildung der Tonwerte beiziehen. Neulich waren in 3Sat Kurzfilme der 50er Jahre zu sehen, und bei einem habe ich meinen Augen nicht getraut: eine Strasse, nichts geschah, ausser dass die Kofferraumdeckel der Autos, die Randsteine der Strasse und die Regentraufen der Dächer sich in stetiger, deutlich wahrnehmbarer Bewegung zueinander befanden, und ich mich fragte, ob hier ein besonders listiger Experimentalfilmer am Werk war. Kurz darauf hatte ich von Snell & Wilcox den MPEG Preprocessor Prefix zum ausgiebigen Test im Atelier, und wusste danach, was ich auf 3Sat gesehen hatte: ein falsch, also zu stark eingestellter Rekursivfilter, der aus dem schwimmenden Bildstand des Filmes nun den Aufstand der Objekte probte. Was aber hier deutlich über die Sichtbarkeitsgrenze gestossen ist, geschieht unterhalb dieser immer auch, wenn wir komprimierende Systeme, und man müsste sie wirklich konsequent als “kompromittierende” Systeme zu bezeichnen beginnen, einsetzen. Doch wir wollen hier eigentlich nicht die Platte der bösen Artefakte auflegen, die dann in Zukunft bei erneuter Decodierung und Encodierung verstärkt hervortreten. Wir sollten uns nun ernsthaft ein paar Gedanken über die Substanz des elektronischen Bildes machen.  Abb 1: Videosignal sichtbar gemacht: Waveform einer einzelnen Zeile (Normfarbbalken)  Abb 2: Claim Excerpts, Vito Acconci, 1971 (mit freundlicher Genehmigung des Künstlers)  Abb 3: Nachziehende Kanten, systembedingt oder nicht optimierter Frequenzgang von Kamera oder Recorder (oder eine Mischung von allen dreien). Auf Video übertragener Werbefilm (Pattex), Videokopie datiert auf 1969, Sony ½” CV  Abb 4: Auf Video übertragener Dokumentarfilm, U-matic, frühe 80er Jahre. Ausschnitt mit Staubfaden  Abb 5: Einzelner, kurzer Drop-out  Abb 6: längerer Drop-out, eine gesamte Zeile Substanz und Integrität des Signals [Abb. 1] Wir kennen in der Restaurierung ja bekanntlich das Prinzip der Substanzerhaltung, weil sie sozusagen die Originalität garantiert und damit auch die Funktion des Kunstwerkes respektiert. Notwendige Eingriffe an dieser Originalsubstanz sollen soweit möglich reversibel sein. Im Bereich des technischen Kulturgutes, aber selbstverständlich auch der elektronischen Medien, wenn es nämlich um die historischen Installationen geht, ist Substanzerhaltung in ein dichotomisches Verhältnis zur Funktionserhaltung geraten: Verschleissteile sind auszutauschen, damit die technische Funktion aufrechterhalten werden kann, welche schliesslich auch die kultische Funktion ermöglicht. Das Verhältnis zur Originalsubstanz ist da also gewissermassen notwendigerweis am verlottern. Sie wissen alle, dass in den Bewegtbildmedien früher oder später der Informationsträger degradiert – am besten kommt der Schwarzweissfilm weg, relativ schlecht das Magnetband. Wir haben hier also den Originalbegriff im Sinne des fetischisierten Objekts schon verlassen, wir haben auch noch das Magnetband als Objekt der Sammlung zu verlassen, aber wir haben bisher zuwenig über diejenigen Grössen reflektiert, welche eigentlich die Substanz des Bildes ausmachen, es sozusagen unverwechselbar und historisch geprägt erscheinen lassen. Zur Substanz gehören sicher die geometrischen Örter des Bildes sozusagen, also keine Verzerrungen über die gesamte Bildfläche. Es gehören dazu die Tonwerte, also Kontrast, Helligkeit, Gamma.[Abb. 2] Flach soll flach bleiben, wenn es das Produktionsgerät der Zeit und die vorhandenen Lichtverhältnisse so gemacht haben. Geräte ohne Schwarzwertklemmung, und das war das gesamte frühe Schwarzweiss-Equipment im Bereich Industrie und Überwachung, also auch der Kunst, haben bei zu wenig Licht das Bild im Grau eingemittet, und nicht schwarz werden lassen. Dies sollte eine Restaurierung so übernehmen, bzw. eine spätere Schwarzklemmung rückgängig machen, wenn aufgrund von Abbildungen beispielsweise das verwendete Equipment und sein diesbezügliches Verhalten ermittelt werden kann. Ein Schwarzwertmodul kann leicht entwickelt werden als Plug-in. Zur Substanz gehört die Wiedergabe der Kanten beispielsweise.[Abb. 3] Bereits die Kamera der 70er Jahre hatte eine sog. Aperturkorrektur, also ein einfache Kantenschärfung. Der Videorecorder hatte sie auch, das ist mit analoger Technik relativ leicht zu bewerkstelligen, mathematisch gesehen ist es die Beimischung der Ableitung zweiter Ordnung des Signals. Zur Substanz gehört auch das dem Medium inhärente Bildrauschen. Es ist auseinderzuhalten von dem Rauschen, was infolge Kopieren oder Degradation dazugekommen ist. Nicht jedes Rauschen ist zu unterdrücken, wir haben hier vermehrt auch historisch informiert vorzugehen. Geräte und Bandmaterial aus der Zeit in plausiblem Zustand geben Auskunft darüber, wie es ausgesehen hat. Das Beispiel von Pattex ist auf der Spule mit 1969 datiert, die Sony CV – Maschine ausgewählt aus drei Exemplaren. Weitere sind vorhanden, denn man hat nie zuviel davon – gibt es doch keine Ersatzteile mehr. Das Band spielt in perfekter Qualität nahezu ohne Dropouts und wäre für die frühesten europäischen Kunstbänder eine mögliche Referenz, um beispielsweise einen “Fingerprint” des Rauschens zu nehmen. Die spektrale Analyse des formattypischen Rauschens würde eine Identifikation und Typologie ermöglichen und den Teil der Signalverarbeitung innerhalb des restauratorischen Prozesses zu verwissenschaftlichen helfen. Alchemie ist gut, Erfahrung ist besser, Messbarkeit und Wiederholbarkeit ist das Ziel. Zur Substanz des Bildes gehört auch das, was ich provisorisch mal die Mikrogeometrie nennen möchte. Phänomene, wie sie das erwähnte malträtierte Filmbeispiel auf 3Sat gezeigt hat, sind schlicht unakzeptabel. Weil wir wissen, dass die Kompressionen beispielsweise der MPEG-Familie solche Bewegungen im Bereich der Mikrogeometrie zulassen, sind sie für unsere Zwecke stärkstens kompromittiert. Es ist davon auszugehen, dass Kompression zwar für die Übertragung und die Diffusion im Publikumsbereich ein Thema bleibt, aber aufgrund der fallenden Speicherpreise in der Konservierung bald einmal Episode werden sollte. Wir haben jetzt die Möglichkeit, die Substanz nahezu verlustfrei weiterzutragen. Es kostet im Moment noch mehr als die Speicherung auf Band, aber der Break-Even Point dürfte in zwei bis drei Jahren überschritten sein. Bandmaterial in Broadcast-Formaten wird nicht billiger, Harddisk-Kapazität hingegen schon. Wir können also unsere Energie besser einsetzen – und zwar in zwei Richtungen: Wenn wir uns für die Substanz entscheiden und nicht für die Aufbereitung eines gerechneten Surrogates, dann haben wir uns der alten Hardware einerseits und der Physis und der Chemie des Bandes anderseits zu widmen. Der Kopf zu Band – Kontakt im Moment des Abspielens ist entscheidend für die Qualität der Substanz, die wir zwar im Band belassen, aber die wir natürlich so tief wie möglich lesen wollen. Doch das ist nicht Thema hier. Wenn ich bis hierher den Anschein erweckt haben sollte, eigentlich ein Skeptiker der digitalen Bildrestaurierung zu sein, so gibt's darauf ein Ja einerseits, aber auch ein vehementes Nein. Wenn ich die Mikrogeometrie des Bildes als ihm zutiefst eigen nicht antasten möchte, so nur in einer Richtung nicht: in der vertikalen. Lassen Sie mich erklären: Wenn ein Film Schaden nimmt in Form eines Kratzers beispielsweise oder wenn aus Unachtsamkeit Staub mitkopiert wurde, so sind dies grundsätzlich flächige Phänomene in derselben Ebene wie das Bild.[Abb. 4] Ich brauche also eine Software, welcher ein Flächenmodell (mindestens) zugrundeliegt. Wenn ein Videoband einen Drop-out hat (das sind die mehr oder weniger kurzen aber heftigen Blitze: Signalausfälle am Videokopf, welche von der Demodulatorschaltung dann leider in krasse Schwarzweiss-übergänge mit nachziehenden Fahnen umgesetzt werden), dann benötige ich ein anderes Modell.[Abb. 5 und 6] Um mit ihnen richtig umgehen zu können, brauche ich eine Software, welcher ein Zeitmodell zugrundeliegt. Die Störung ist nicht ausgedehnt in x und y – Richtung, sondern sie dauert vom Zeitpunkt t1 bis t2. Im Bild ist das ein Streifen mit einer Länge, welche der Zeitdauer t2 – t1 entspricht, aber keiner geometrischen Höhe, sondern der Stärke einer Bildzeile. Wenn sie länger dauert, sind selbstverständlich mehr Zeilen involviert, was aber immer noch nicht einer Höhe im Bild entspricht, sondern allenfalls einer Höhe auf dem Bildschirm. Wieso bestehe ich so explizit auf diesem Umstand? Bei geometrischen Formen im Bild muss ich ja eine Zone des Ersetzens definieren, welche üblicherweise weich ausschneidet und einsetzt, damit keine Kantenartefakte entstehen. Wenn ich einen Dropout flächig ersetze, tangiere ich dabei ein Vielfaches an originaler Bildsubstanz, als wenn ich nur seinen Anfang und sein Ende in der Weichheit von 2 – 3 Pixeln treffen muss. Zwei benachbarte Zeilen, das Interlacing mal nicht berücksichtigt, haben keinen kohärenten Zusammenhang wie etwa die Silberschicht im Film, auch und besonders wenn sie beschädigt wird. Zwei benachbarte Zeilen im Video haben sich das letzte Mal in der Kamera getroffen, danach sind sie immer 64 µs bzw. 20 msec nacheinander unterwegs, und das seit 20 oder 30 Jahren. Detektion ist eine Sache, reparieren eine andere: Ein Drop-out ist seiner Definition nach ein einmalig auftretender Fehler, und die Information, die er verdrängt hat, ist im Falle eines unbewegten Bildes zwei Halbbilder zuvor oder danach verfügbar. Habe ich Bewegung im Bild, so gibt es zwei Möglichkeiten des Ersatzes: Rückgriff auf das entsprechende vorangegangene Halbbild, aber im genauen Ort korrigiert um einen Bewegungsvektor, der mir die Motion Prediction angeben kann, oder aber ich errechne die Information aus den örtlich benachbarten Zeilen, eine an sich bekannte Prozedur. Wichtig ist dabei der Grundsatz, dass ich nur fehlende Teile neu berechne, und sie allenfalls auch mit den charakteristischen Mikrostrukturen versehe.  Abb 7: kurzzeitiger Trackingverlust infolge Gleichlaufschwankung, führt zu verrauschten Bildzonen  Abb 8: Signalform einer Gleichlaufschwankung (simuliert), 20 Zeilen  Abb 9: Messignal: senkrechte Linien erscheinen durch die Gleichlaufschwankung verwellt  Abb 10: Kräftige seitliche Verwellung über 7 Zeilen: zugehöriges Waveform-Signal (simuliert)  Abb 11: Massive Gleichlaufschwankung infolge klebenden Band (Sticky Tape Syndrome). In der restauratorischen Praxis wird natürlich versucht, das Band vor dem Abspielen wieder lauffähig zu machen. Residuale Verzerrungen bleiben aber bestehen. Videoband, vermutlich frühe 80er Jahre, Sony ½” AV  Abb 12: Verzerrungsform bei fehlerhaft justierten Videoköpfen. Ist das Originalband vorhanden, so kann das Abspielgerät auch heute noch auf das Band hin exakt eingestellt werden: unbedingtes Plädoyer für die klimatisch richtige Aufbewahrung der Originale  Abb 13: Seitlicher Verzug am oberen Bildrand infolge Kopfversatzes des Aufnahme- oder Wiedergabegerätes, 1 Halbbild  Abb 14: Seitlicher Verzug am oberen Bildrand infolge Kopfversatzes des Aufnahme- oder Wiedergabegerätes, 2 Halbbilder übereinander  Abb 15: Testbild, mit Brummspannung überlagert. Durch die Brummspannung wird sowohl die Bildhelligkeit, als auch die seitliche Lage der betroffenen Zeilen verschoben, weil der Zeilensynchronpuls bereits vor dem “richtigen” Zeitpunkt den Schaltpegel durchschreitet Schauen wir uns eine etwas kompliziertere Geschichte an: das Lesen eines Videobandes ist eine komplexe kinetische Angelegenheit, die im einfachsten Fall der Frühzeit darin besteht, dass ein bis zwei Videoköpfe ständig in der richtigen Tourenzahl und zudem dem exakten Drehwinkel, bezogen zum Band, drehen: sonst fällt das Bild durch oder ich habe ein partiell verrauschtes Bild, weil die Spurlage nicht stimmt.[Abb. 7] In den frühen 70er Jahren wird auch die Bandgeschwindigkeit regelbar. Alle diese mechanischen und elektronischen Komponenten sind gut aufeinander abgestimmt. Hat ein Gummiriemen etwas mehr Schlupf oder weist ein gealtertes Band nicht mehr dieselben Reibungs- bzw. Gleiteigenschaften auf, gerät mein Regelsystem aus dem Trott und beginnt sichtbar zu kompensieren. Es ist dann manchmal etwas zu schnell, um dies gleich danach wieder wettzumachen. Das resultierende Videosignal wechselt also dauernd zwischen etwas zu früh und etwas zu spät. Dies ist in den folgenden Oszillogrammen zu sehen, zuerst normal einige Videozeilen nacheinander (auf dem Bildschirm sind sie dann übereinander), danach leicht aus dem Takt, schliesslich schwer aus dem Takt.[Abb. 8] Auf dem Bildschirm wirkt sich das etwa so aus, wie in [Abb. 9] zu ersehen ist. Die Sache ist extra für diesen Anlass simuliert, in der harten Wirklichkeit lässt sich das leider nicht so schön sichtbar machen, oder dann mit einem deutlich höheren Aufwand. Auch wenn Sie da nun nicht sofort durchsehen sollten, wofür ich Verständnis hätte, halten Sie eines fest: zeitliche Fehler sind im Bild vorerst seitliche Verschiebungen. Mit diesem Time-Base Error kann man seit über 30 Jahren umgehen: das Gerät heisst folgerichtig Time-Base-Corrector, kurz TBC. Er liest das Signal ein so früh und so spät wie es kommt, und legt es im Speicher ab, Referenz für den Speicherort ist der Synchronimpuls, der Zacken hier im Oszillogramm, der da jeweils auf die Grundlinie taucht bzw. auf die nominellen 0 Volt herunter. Beim Auslesen aus dem Speicher geht's nun quarzgenau und mit neuen, unverschliffenen Synchronimpulsen versehen auf die Reise. Und das ist genau der Haken: Schlecht gelesene, mit Jitter überlagerte Synchronimpulse produzieren neue Zeitfehler, welche nun aber als Bildinhalte festgeschrieben sind, dazu kommen zeitliche Kontraktionen und Dehnungen innerhalb der Zeile. In der Regel wird noch einer der beiden elektronischen Bildränder neu begrenzt, weil ein Einmitten nicht möglich war oder nicht erfolgt ist – entfernt vergleichbar übrigens mit einer unsorgfältig justierten optischen Bank für die Erstellung einer Filmkopie. Eine Software, welche diesen Zeilenversatz aus dem Bildinhalt heraus detektieren will, stösst an Grenzen, besonders wenn der Versatz nicht abrupt ist, wie dies einer der Spezialisten auf dem Gebiet, Anil Koharam, in einem dem Thema gewidmetem Aufsatz anmerkt. Hätten wir alle Informationen noch unkorrigiert, nämlich Synchronimpuls, linke und rechte Schwarzschulter, linker und rechter Bildrand, wie in einem kontinuierlich digitalisierten Signal [Abb. 10], so könnten wir alle diese Kanten auswerten und mittels einer Art Slow Fourier Transformation zu einer Time Base Prediction kommen anstelle einer Motion Prediction , welche unseren Zeilenversatz schön auf die Reihe zu bringen vermöchte. Weil der Synchronteil und die Ränder teilweise verstümmelt wurden [Abb. 11], sind entsprechende Indikatoren auch aus den Bildinhalten, sprich vor allem vertikalen Kanten, zu gewinnen. Dummerweise gibt es die nicht immer, so dass die Prozedur am besten alle auswertbaren Daten in ein Plausibilitätsmodell setzt, welches uns eine Korrekturkurve für die Timeline liefert. Es ist davon auszugehen, dass diese Kurve sowohl einen zufällligen Verlauf nimmt ebenso wie sie Regelmässigkeiten aufweist. Auch da also Prinzip Fingerprint, welche eine bessere Diagnostik und Voraussage der zu wählenden zeitlichen Entzerrung erlaubt. Dieser Weg wird in der Audiorestaurierung beschritten. Eine weitere Gruppe von Fehlern betrifft in leichteren Fällen nur den unteren, in schwereren aber auch den oberen. Es geht um Kopfumschaltpunkt und Kopfversatz [Abb. 12]. Es sind Fehler, die eigentlich bei präzise eingestellten Geräten kaum stören würden. Im frühen Video, den Inkunabeln sozusagen, treffen wir aber auch anderes an. Die Genfer Kopie von Claim Excerpts von Vito Acconci bietet einige solche Leckerbissen.[Abb. 13] Kopfversatz, also nicht genau gegenüberliegende Videoköpfe, beginnen das eine Halbbild immer ein wenig zu früh, das darauf folgende immer etwas zu spät zu lesen (und natürlich auch: aufzunehmen). Trichterförmiges Auseinanderdriften vertikaler Linien, selbstverständlich aber des gesamten Bildinhaltes am oberen Rand ist die Folge, [Abb. 14] am unteren ist eh die Hölle los. Monitore haben diese Partie tendenziell verdeckt durch den Rand der Röhre oder deren vorgesetzter Blende, mit den Flachbildschirmen und den Projektoren sehen wir auf einmal alles – aber diese Geschichte schneiden wir heute nicht an. Ein Korrekturmodell, welches die Zeitkonstante des Regelkreises ermitteln kann, dürfte hier auch präziser sein als eine Flächen- oder kantenorientierte reine Bildlösung. Zu guter Letzt noch ein Netzbrumm, wie er sich bei unsauberer Studioverkabelung gerne ins Bild einschlich.[Abb. 15] Sind mehrere Geräte miteinander ringförmig verkabelt, so kann ein Potentialausgleich über die Abschirmung der Signalleitung, sei dies Ton oder Bild, erfolgen und leider seine Spur im Signal hinterlassen. Es wandert dann ein mehr oder weniger weicher, oft räumlich wahrgenommener Balken sehr langsam von oben nach unten oder umgekehrt über das Bild. Seine Frequenz ist genau 50 Hz, der zeitliche Abstand von Balken zu Balken genau 20 msec. Wenn diese Regelmässigkeit bekannt ist, sollte händisch oder halbautomatisch das sich in der bestimmten Gerätekonstellation nicht verändernde Störprofil zu exzerpieren und gegenläufig auf die Helligkeitswerte des Bildes anzuwenden sein. Diese Rechnung ist dann wesentlich einfacher, als wenn sie aus jedem Bild heraus zu starten wäre. Meine Vorschläge verstehen sich als Anregung, bestehende Module einer Restaurierungssoftware zu ergänzen oder andere ganz neu anzudenken, insbesondere dort, wo sie bisher schwer lösbare Fehler mit Sicherheit präziser anzugehen versprechen. Die genaue Kenntnis der alten Videofehler sowie derjenigen, die aufgrund der Degradation von Hardware und Magnetband neu entstanden sind oder sich verschärft haben, verspricht viel präzisere Eingriffe bei gleichzeitig weitgehender Substanzerhaltung im erläuterten Sinn. Alle realen und simulierten Aufnahmen ab Bildschirm oder Oszilloskop durch den Autor, im gemeinsamen Medienlabor der AktivenArchive und der Vertiefungsrichtung Moderne Materialien und Medien des Fachbereichs Konservierung und Restaurierung, Hochschule der Künste Bern HKB |

|

||||